Tensorflow와 호환되는 CUDA, cuDNN 설치하는 법

Tensorflow와 그 버전과 호환되는 CUDA, cuDNN까지 설치하는 법

이번 글에서는 Tensorflow 설치법부터 그 Tensorflow의 gpu와 호환되는 CUDA, cuDNN 설치법까지 설명해보겠다.

(설치할 기기는 NVIDIA GPU를 사용하고 있어야 한다)

1. Anaconda를 설치한다

기본적인 패키지들을 포함한 개발환경을 구축하기 위해 아나콘다를 깔아준다. 아나콘다를 이용하면 귀찮게 여러 가지 패키지들을 따로 깔아줄 필요가 없다. (물론 아나콘다의 단점도 존재합니다)

Anaconda 링크: https://www.anaconda.com/distribution/#download-section

Anaconda Python/R Distribution - Free Download

Anaconda Distribution is the world's most popular Python data science platform. Download the free version to access over 1500 data science packages and manage libraries and dependencies with Conda.

www.anaconda.com

2. Anaconda Prompt로 Tensorflow 설치한다

# stable한 버전의 tensorflow가 설치된다

pip install tensorflow 3. 무슨 버전의 Tensorflow를 깔았는지 확인한다

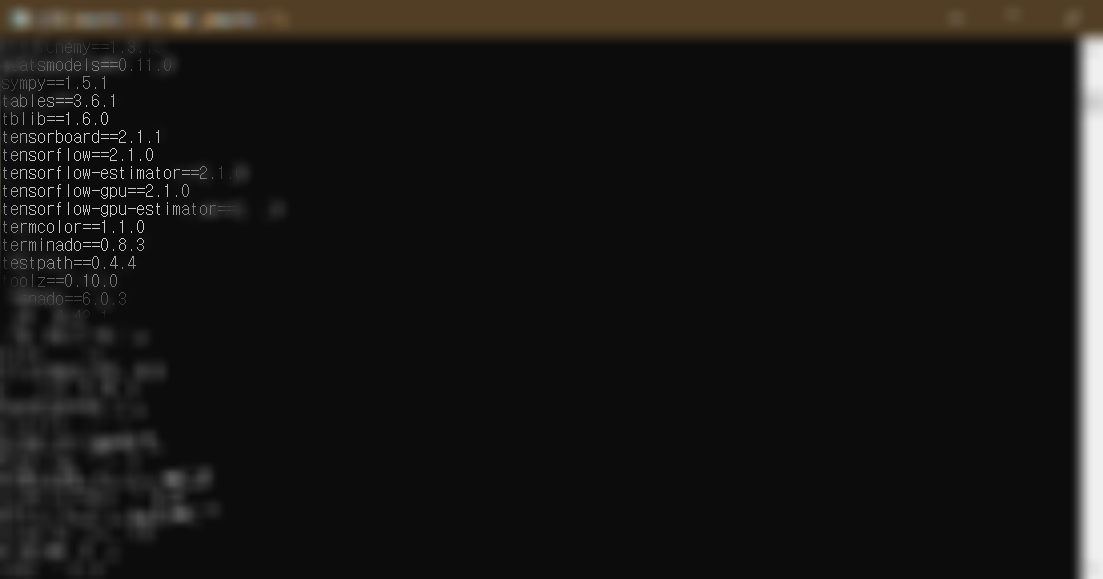

# 아나콘다를 통해 깔려있는 모든 것들이 나열된다

pip freeze

4. 내가 설치하고자 하는 tensorflow gpu와 호환되는 CUDA, cuDNN 버전을 확인한다

호환되는 CUDA와 cuDNN 버전은 아래 링크에서 확인할 수 있다.

Windows: https://www.tensorflow.org/install/source_windows#tested_build_configurations

Mac / Linux: https://www.tensorflow.org/install/source#tested_build_configurations

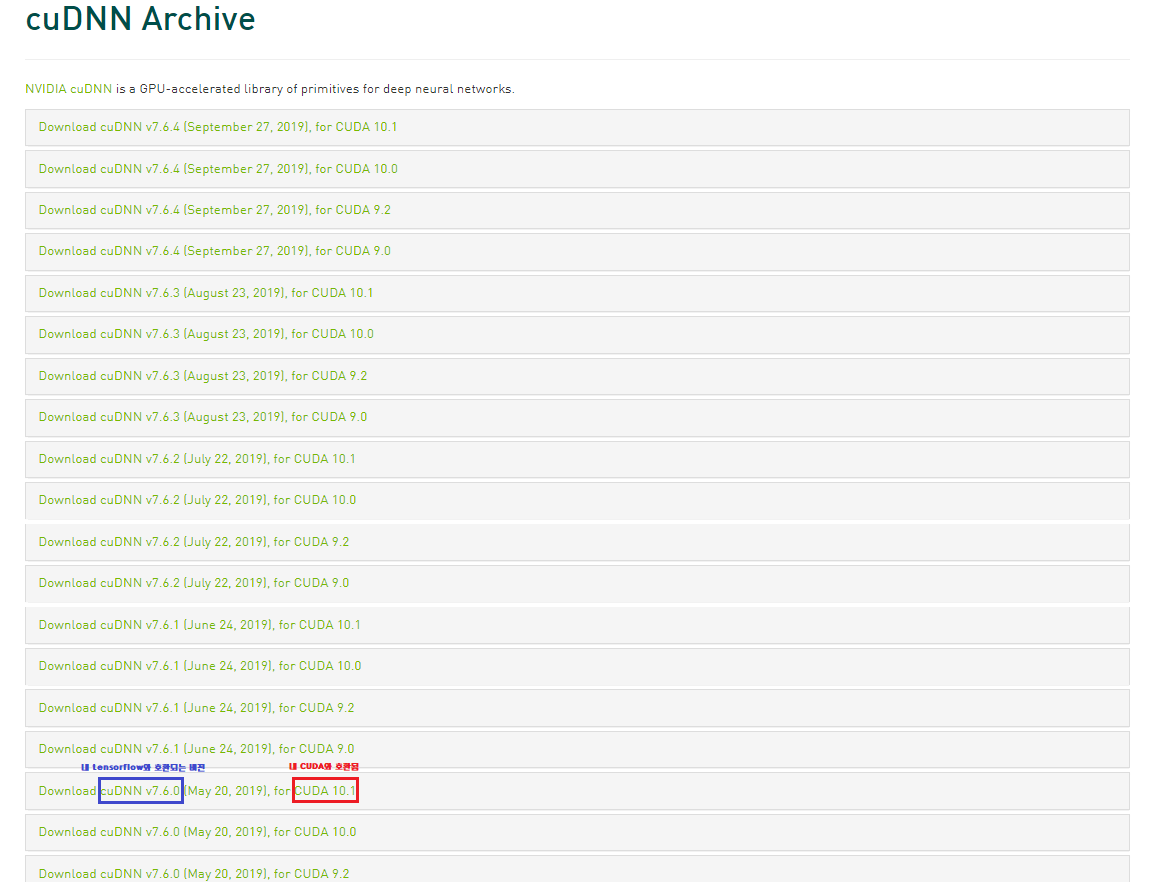

나에게 해당하는 tensorflow_gpu-2.1.0와 호환되는 버전은 다음과 같다. 이것을 예로 해서 호환되는 CUDA와 cuDNN을 설치하는 법을 설명하겠다.

- CUDA: 10.1

- cuDNN: 7.6

5. 호환되는 버전의 CUDA를 설치한다

NVIDIA 사이트의 CUDA Archive에서 원하는 버전의 CUDA를 선택해서 다운로드한다.

NVIDA CUDA Toolkit Archive 링크: https://developer.nvidia.com/cuda-toolkit-archive

6. 내 Tensorflow와 호환되면서 내 CUDA와도 호환되는 버전의 cuDNN을 다운로드한다

NVIDIA 사이트의 cuDNN Archive에서 원하는 버전의 cuDNN을 선택해서 다운로드한다.

* NVIDIA 회원가입을 해야 cuDNN을 다운로드할 수 있습니다.

NVIDIA cuDNN Archive 링크: https://developer.nvidia.com/rdp/cudnn-archive

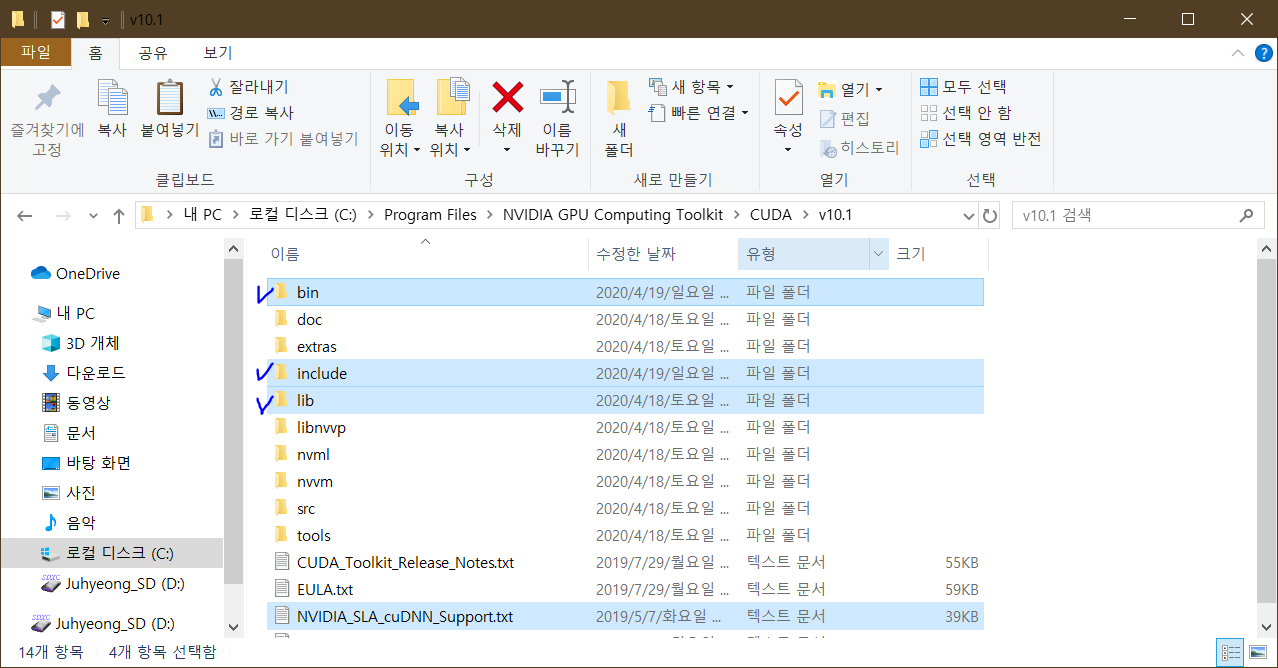

7. 다운로드한 cuDNN 파일의 압축을 풀고 각각의 폴더에 해당하는 파일들을 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v버전의 폴더로 옮긴다

나는 CUDA 버전이 10.1이어서 파일의 옮길 경로는 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.1이다. (C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA에는 v버전명 폴더 하나만 있을 것이다. 그렇기 때문에 경로를 혼동할 일은 크게 없을 것 같다)

그리고 압축을 푼 cuDNN 파일들을 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.1로 옮겨서 bin, include, lib 폴더를 덮어씌웠다.

(덮어씌우는 방법 외에도 cuDNN을 따로 두고 cuDNN의 Bin파일 경로를 Path 환경변수에 추가해서 경로를 잡아주는 방법도 있다. 여기서 다루진 않지만 CUDA에서 에러가 계속 발생한다면 이 방법을 시도해보는 것을 추천한다.)

8. 호환되는 버전의 tensorflow gpu를 설치한다

# 호환되는 버전의 tensorflow gpu를 깔아준다.

# 다음과 같이 버전을 명시해서 패키지를 깔 수 있다.

# `pip install tensorflow-gpu==버전`

# 나는 2.1.0을 깔아야 해서 다음과 같은 명령어로 깔았다.

pip install tensorflow-gpu==2.1.09. 마지막으로 잘 작동하는지 확인한다

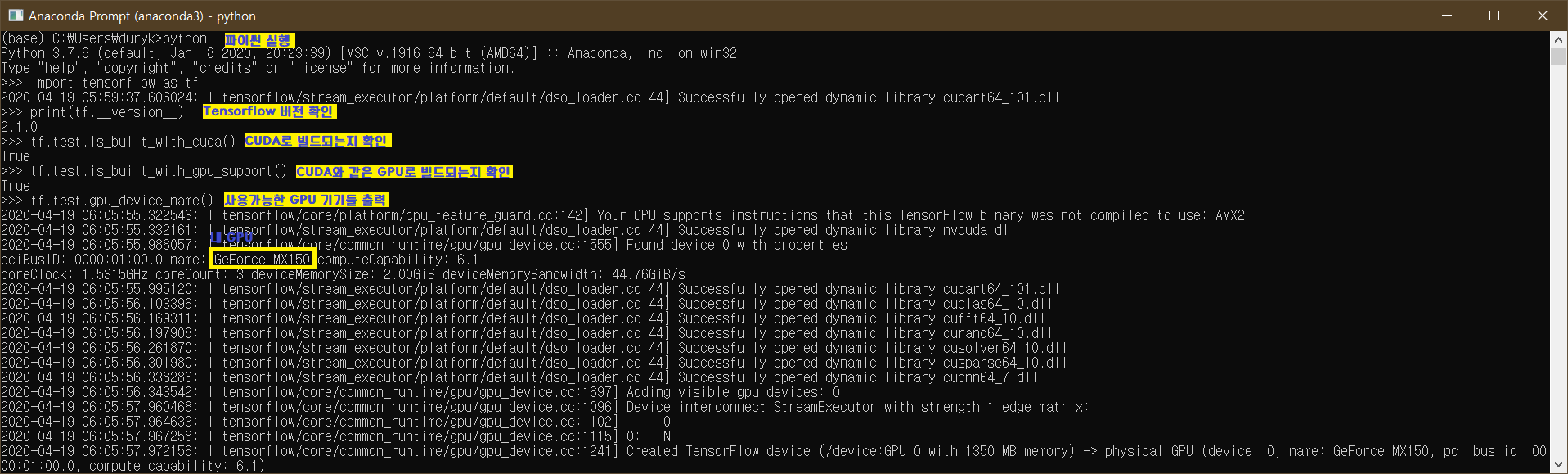

CUDA 경로를 잘잡아주는지도 체크하고 Tensorflow code를 실행해서 어디서 실행이 되는지도 확인해주면 된다.

1. CUDA 확인하기: Anaconda Prompt에서 nvcc --version

2. Tensorflow Code 실행

먼저 Anaconda Prompt에서 python이라고 쳐서 파이썬을 실행한다. 그리고 tensorflow의 test 모듈로 잘작동하는지 확인해본다. (ex)test.is_built_with_cuda() 함수로 CUDA GPU가 작동하는지 확인할 수 있다.

다른 test 모듈의 함수들은 https://www.tensorflow.org/api_docs/python/tf/test에서 찾을 수 있다.

출처

-

Icons made by Freepik from www.flaticon.com

댓글

이 글 공유하기

다른 글

-

나의 온라인 컴퓨터공학 공부

나의 온라인 컴퓨터공학 공부

2020.05.04 -

정보처리기능사 필기 하루 컷 후기

정보처리기능사 필기 하루 컷 후기

2020.04.23 -

편리한 Visual Studio 단축키 정리

편리한 Visual Studio 단축키 정리

2020.04.15 -

[CMD] 내가 연 폴더를 바로 Working Directory로 설정하기

[CMD] 내가 연 폴더를 바로 Working Directory로 설정하기

2020.02.28